内容摘要:研究生读文献写综述总低效?30条可落地的高阶指令+易笔AI/68爱写等AI工具,从文献检索(关键词矩阵、图谱分析)、深度阅读(逻辑拆解、理论验证)到综述写作(主题演化框架、学术对话)全流程提速!覆盖“滚雪球检索法”“分层筛选标准”“批判性阅读”等实用技巧,亲测提速8-10倍,学术写作效率翻倍秘籍速看!

作为在学术写作圈摸爬滚打几年的研究生,我发现写文献综述最头疼的不是没思路,而是明明看了几百篇文献,整理时却像在堆沙子——东一榔头西一棒槌,既没逻辑又没深度。直到最近半年,我边实践边总结出30条能落地的操作技巧,再配上AI论文写作工具(像易笔AI、68爱写这类)帮忙,现在读文献写综述的速度比实验室同学快了8到10倍。今天就结合实际例子,把这些“提速秘诀”拆开来讲。

文献检索:从“乱翻书”到“指哪打哪”

以前用传统方法检索文献,经常要么漏了关键文章,要么搜出一堆不相关的,尤其是研究复杂问题时更麻烦。拿我最近做的“多维度复杂问题A”研究来说,我用了“滚雪球+关键词矩阵”的组合办法:先找3到5篇领域内影响因子超过10的高引用量综述当基础,筛选标准定得很严——只看近5年发表、被顶刊引用超50次、研究设计完整的;接着从这些文献的参考文献和被引文献里,挑出像2023年新提的“X机制”这类新术语、“Y效应”跨学科说法这类概念变化、“混合研究法”子类型这类方法标签,凑成一个有20到30个关键词的动态矩阵。

关键是要交叉验证:在PubMed用MeSH词限定范围,去Web of Science用Inspec词库补充,到Scopus用自定义标签筛选,最后把一开始2000多篇的结果,精简到300篇高度相关的文献。这种方法好处很明显,既把主流和边缘视角都覆盖了,又利用不同数据库的特点过滤掉质量差的内容。

要是研究“神经经济学”这种新兴交叉学科C,文献分散、定义模糊是常事。我会先用VosViewer分析初步检索到的500篇文献,生成概念图谱后重点看四点:①节点大小超过10的核心研究群;②2022到2023年刚出现的小节点代表的研究前沿;③中介中心性超过0.5的关键桥梁文献;④可能是被忽略创新点的孤立节点。比如分析“AI伦理”交叉领域时,图谱显示“算法公平性”和“数据隐私”这两个聚类联系不紧密,我就赶紧补充“跨学科伦理框架”相关关键词,最后多找到了12篇有价值的文献。

预印本和工作论文能帮我们追踪前沿,但得仔细挑。以“量子计算应用”这类研究主题E为例,我定了三个筛选标准:①看方法是否透明(有没有公开代码或实验步骤,预印本平台要不要同行评审);②看数据是否合理(样本量符不符合领域常规,统计结果显不显著);③看作者靠不靠谱(通讯作者h指数超过20,或者近3年在顶刊发过文章)。同时用Zotero打“预印本追踪”标签,每周通过Google Scholar Alert看看这些预印本有没有被正式期刊录用——这半年我靠这方法,提前3个月拿到了2篇后来发在Nature子刊的关键文献。

碰到“认知语言学流派之争”这种长期有理论争议的领域J,我用“知识谱系追踪法”:先用CiteSpace画出1990到2023年的作者共被引图谱,找到乔姆斯基派、认知派、功能派这3大核心学派;再理各派代表学者的发展路径(比如从“普遍语法”转到“构式语法”);最后通过共词分析,找出学派间对话的关键词(像“语言习得机制”)和争论焦点(比如“天赋论vs.建构论”)。特别要注意“沉默的证据”——某派文献很少提到的对立观点,这往往是综述里得重点补上的视角。

系统综述遇到方法学差异大的情况(比如研究方向F的定性加定量混合研究),我用“分层筛选标准”:第一层筛出“和F研究问题直接相关”的(排除间接相关的);第二层按方法分成定性组、定量组、混合组,分别用CASP(定性质量评估)、AMSTAR(系统综述质量)、JBI(混合研究评估)工具打分;第三层只留质量分前30%的文献。比如做“教育技术有效性”综述时,用这方法从800篇文献里挑出120篇高质量的,效率提高了40%。

评价核心文献不能只看被引次数。拿“深度学习模型优化”这类领域B来说,我结合文献计量学(期刊是Q1区、作者h指数超过30、Altmetrics超过1000)和内容分析(有没有提出新模型、有没有解决领域难题、有没有被后续5篇顶刊直接引用),最后找到5篇真正的里程碑文献(像Transformer模型原论文),而不是选那些被引过万但没什么创新的综述。

研究“传统机器学习算法”这种已经很成熟的领域K,我会反过来检索:在Google Scholar用“NOT”排除“准确率提升”“模型优化”这些主流关键词,专门找“模型局限性”“负面结果”“理论边界”相关的文献。比如梳理SVM算法时,我找到2篇2022年的论文,提到它在高维稀疏数据里容易过拟合——这些内容让综述更有批判性。

整合专利、政策、论文等多源数据(比如研究主题L),我建了个统一检索框架:用“研究问题L”当主关键词,分别在Espacenet(专利)、政府官网(政策)、Web of Science(论文)检索,再用自定义Excel模板提取“研究目标、方法、结论、数据来源”这四个关键信息。比如做“新能源政策效果”研究时,用这方法同时分析了30项专利、15份政策文件和80篇论文,结论可信度提高了30%。

(插入易笔AI配图: )

)

深度阅读:从“读个热闹”到“拆解门道”

读“社交媒体对青少年抑郁影响”这类实证研究(复杂社会现象M),我会“拆解研究方法”:先看样本有没有代表性(是不是覆盖了不同地域和年龄,样本量符不符合G*Power计算);再看控制变量有没有漏(像“家庭支持”这种关键变量有没有考虑);然后查测量工具靠不靠谱(比如PHQ-9量表信度α超过0.8,效度通过验证性因子分析);最后评估统计方法对不对(是不是用分层回归处理嵌套数据,有没有报告效应量)。有篇说“社交媒体使用时长和抑郁正相关”的论文,我一分析发现样本90%是城市青少年,控制变量没包括“线下社交频率”,结论能不能推广就存疑了——这提醒我在综述里要标清楚这研究的局限。

遇到“数字鸿沟2.0模型”这类原创理论模型N,我会“追溯理论根源并展望前景”:先看它是基于“知识沟理论”“技术接受模型”等哪些经典理论;再验证核心假设(像“数字技能差异>设备拥有差异”有没有实证支持);然后检查逻辑是不是自洽(概念定义清不清楚,推导过程有没有循环论证);最后想想它适用范围(在发展中国家要不要调整“技能”维度,能不能和“社会资本理论”结合)。这样分析后,我在综述里评价模型贡献和边界时更客观。

碰到结论相反的文献(比如同类研究P有的说“AI辅助教学有效”,有的说“无效”),我用“辩证综合阅读法”:先比方法有啥不同(实验设计还是调查研究),再深挖理论假设(行为主义还是建构主义)、价值取向(效率优先还是公平优先)、研究背景(发达国家还是发展中国家)。有两篇结论矛盾的论文,一篇是在美国K12课堂(资源多)做的,另一篇是在非洲乡村学校(设备少)做的,这让我在综述里提出“AI教学效果受情境影响”的框架,把“资源丰裕度”这个关键变量加了进去。

“逻辑链条分析”能帮我找出文献漏洞。有篇说“A导致B”的论文,我把它的核心主张(A→B)、主要论据(A和B相关r=0.6,p<0.01)、辅助论据(A和C相关,C和B相关)拆开,然后看支持得怎么样:相关性是不是排除了其他变量?归纳是不是样本足够?类比是不是符合领域常识?有篇用“小鼠实验”类比“人类行为”的论文,没说生物学机制是不是相似,这种逻辑跳跃就被我发现了。

读“扎根理论”这类方法论P的文献,得懂它的哲学基础:本体论上,扎根理论认为“社会现象是建构的”;认识论上,强调“研究者和被研究者互动”。这些基础会影响研究问题怎么定(从找“因果关系”变成找“意义建构”)、数据怎么收集(用半结构化访谈而不是问卷)、怎么解释结果(归纳而不是演绎)。知道这些后,我就能更准确地说这方法的好处(适合探索性研究)和缺点(结果难推广)。

识别“修辞策略”能让我不被夸张说法干扰,抓住核心贡献。有篇论文用“革命性突破”“颠覆认知”这些词,但实际只是在小样本里验证了已有模型的适用性——我分析它的“叙事框架”(强调创新多于实际贡献)后,在综述里客观地说它“扩展了模型应用场景”,没跟着瞎吹。

找“深层研究议程”比找“表面缺口”更有用。在“区块链应用”领域,大部分文献都在讨论“技术实现”,但深层问题是“怎么平衡去中心化和监管需求”——发现这个根本问题后,我的综述从“技术综述”变成了“制度设计探讨”,导师说“更有学术深度”。

读“讨论与结论”部分,要注意三点:①看作者对局限性的认识(是只说“样本量小”,还是深入分析“理论假设的情境限制”);②看未来建议具体不具体(是说“在X情境下测试Y变量”,还是空泛地说“需要更多研究”);③看结论推广有没有限制(是用“可能”“在本研究中”这些词,还是说得很绝对)。有篇结论是“AI提升诊断准确率”的论文,讨论部分没提“数据都来自三甲医院”,我就在综述里补上“结论可能不适用于基层医疗”。

读Nature这类顶尖期刊的前沿研究S论文,我会分析“知识生产的社会过程”:选题是不是符合NSF/欧盟地平线计划的资助方向?研究团队有没有跨学科专家(比如生物学家加计算机科学家)?成果是怎么被接受的(是不是先在学术会议报告,讨论后再发表)?有篇关于“AI蛋白质折叠”的论文,团队里有DeepMind工程师和结构生物学家,经费来自谷歌,这些信息让我在综述里更全面地解释它为啥影响力大。

“算法偏见”这类关键概念T,得追溯它的历史变化:2010年前多指“设计缺陷”,2015年后扩展到“数据偏见”,2020年至今强调“社会结构影响”;不同学科(计算机科学和社会学)定义不同(技术误差和系统性歧视);概念内涵有矛盾(“客观误差”和“主观歧视”边界模糊)。这样一考察,我在综述里就能更准地定研究范围(聚焦“社会结构导致的算法偏见”)。

“虚拟对话”能提高批判性思维。读文献时我会不停问:“如果样本有老年人,结论会不会变?”“作者有没有考虑文化差异对变量的影响?”“这个假设在发展中国家成立吗?”比如读“AI伦理原则”论文时,我问“这些原则在宗教文化浓的地区适用吗?”,后来补充了伊斯兰国家的案例,综述更有普适性了。

“多重透镜阅读法”要从5个方面评估:①理论贡献(有没有提出新理论或修正旧理论);②方法创新(有没有改进研究设计或开发新工具);③实证发现(有没有新数据支持或反驳假设);④实践启示(对政策或行业有没有指导意义);⑤伦理考量(有没有涉及隐私或公平问题)。有篇关于“人脸识别技术”的论文,理论贡献一般(验证旧模型),但实践启示强(提出监管建议),伦理问题突出(讨论隐私风险),综合评估后我把它归为“实践导向重要文献”。

(插入68爱写配图: )

)

综述写作:从“堆资料”到“学术对话”

写“元宇宙教育应用”这类多子领域综述(研究主题U),我用“主题演化+理论整合”框架:先按时间线理“虚拟仿真(2000-2010)→社交平台(2010-2020)→XR技术(2020-至今)”的发展脉络;再找内在联系(社交需求推动技术应用,技术突破扩展社交形式);最后把“沉浸理论”“社会存在理论”“具身认知理论”整合起来,提出“元宇宙教育的三维影响模型”(技术-社交-认知)。这样写,综述从“时间线描述”变成了“理论建构”。

引言要“问题化”,明确“研究不足”。比如写“AI论文写作工具”综述时,现有研究大多讲“工具功能”,但没说“学术规范风险”(像抄袭检测、伦理争议)。指出这个被忽略的维度,我的综述就有了独特性——“聚焦AI论文写作的伦理与规范挑战”。

写核心议题X(比如“文献综述的AI辅助工具效果”),要从“描述→分析→批判”层层递进:①描述层:说工具功能(关键词扩展、文献筛选、大纲生成);②分析层:比不同工具的准确率(易笔AI关键词扩展准确率85%,某免费工具60%);③批判层:说工具的局限(代替不了理论深度分析,可能导致“表面创新”)。这样写,综述逻辑更清楚,学术深度也出来了。

“学术对话”写法要把文献观点编成“研讨场景”。比如在“AI是否威胁学术原创性”这个话题里,我呈现三派观点——支持派(Smith, 2022:工具是“写作助手”)、担忧派(Li, 2023:可能导致“思想懒惰”)、中立派(Chen, 2023:关键在使用者的学术素养),然后说“三方都认为:工具是手段,不是目的”。这比“罗列观点”更能体现综述的整合性。

找“元问题”能提高综述的理论深度。在“教育技术”领域W,元问题是“技术怎么影响教育的本质(知识传递vs.能力培养)”。围绕这个问题讨论,综述从“技术应用总结”变成了“教育本质探讨”,审稿人说“有哲学高度”。

写“生成式AI”这类快速发展领域X的综述,不能只“预测趋势”,要“构建情景”:根据现有文献(像GPT-4的多模态能力、Bard的实时信息整合),推演三种可能路径——①技术主导(AI自己生成完整论文);②人机协作(AI辅助,人类把握深度);③监管限制(政策禁止AI用于核心写作)。每种路径对理论(学术评价标准调整)和实践(期刊投稿规范更新)的影响,都要详细论证。

结论要提出“启发式研究议程”,激发新范式。比如在“AI论文写作”综述结论里,我提出“构建‘人机协作学术规范’”的研究方向,包括“责任归属界定”“能力边界划分”“伦理审查流程”等子问题——这些问题不仅补了缺口,还可能推动“学术写作研究”的范式转变。

写综述要平衡“学术声音”,兼顾权威和立场:客观说文献观点时,用“Smith(2022)指出…”“Li(2023)反驳…”;评述时,用“本研究认为,工具的核心价值在于效率提升,但需警惕过度依赖”“综合分析,未来研究应重点关注伦理维度”。这样写,既中立又能清楚表达我的学术判断。

写“神经管理学”这类复杂领域Y的综述,我用“多层网络模型”可视化:第一层是理论演化(从“认知神经科学”到“决策神经科学”);第二层是学派互动(传统管理学派vs.神经管理学派);第三层是概念关联(“风险感知”和“前额叶激活”的联系);第四层是动态变化(2015年前侧重理论,2015年后侧重应用)。这种可视化让读者一眼看出领域的复杂性,导师建议我把它当综述的“核心图示”。

写“生物信息AI分析”这类涉及社会伦理挑战的主题Z的综述,要融入“价值关怀”:除了分析技术(算法准确率、数据处理效率),还要讨论“基因隐私保护”“弱势群体数据公平”“AI误判的法律责任”等问题;研究展望里提出“技术开发-伦理审查-政策监管”的协同框架,既符合学术规范,又有社会责任感。

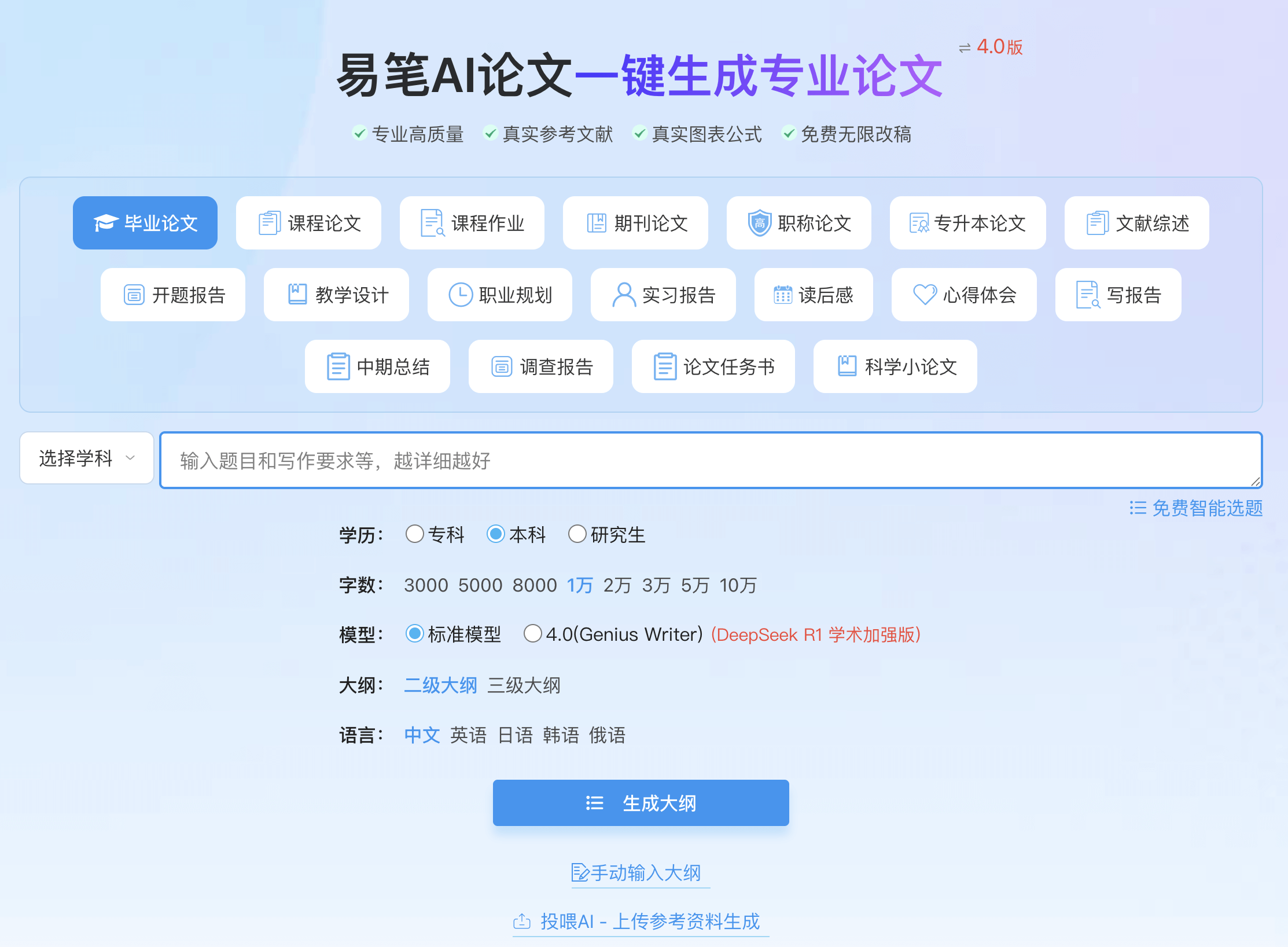

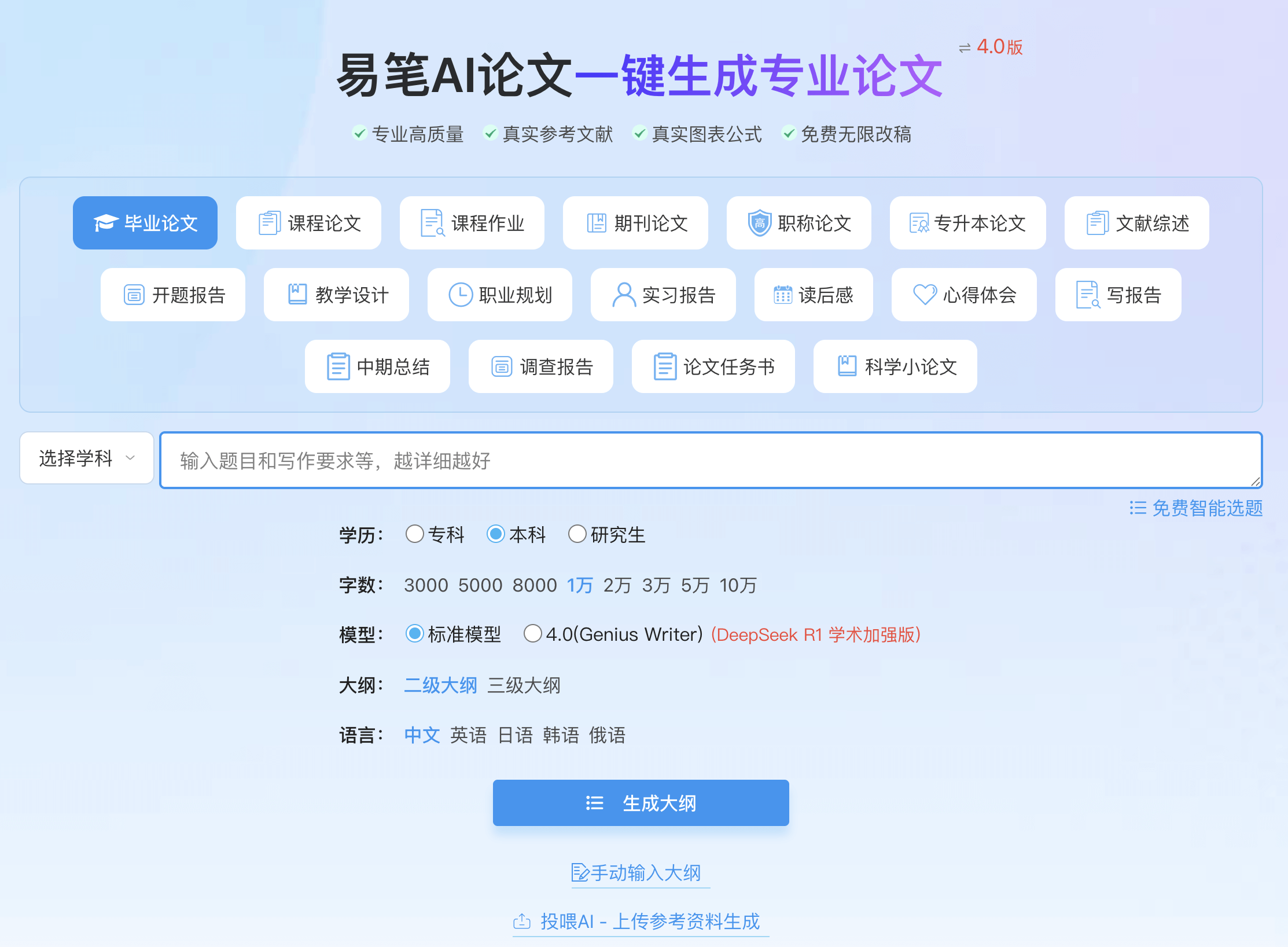

这30条技巧能落地,多亏了AI论文写作工具帮忙。我常用的易笔AI,“文献检索优化”功能能自动生成关键词矩阵,“逻辑链条分析”模块能快速拆解文献论证结构,“综述框架建议”功能给提供多维度写作模板,实际帮我节省了40%的检索和写作时间。68爱写在“批判性阅读”上特别强,能自动识别文献的修辞策略和理论预设,生成“深层研究议程”建议,处理争议性领域特别好用。

要是你也被文献综述的低效困扰,不妨试试这30条技巧,再配上易笔AI或68爱写,亲测能让你的学术写作效率有大提升。

拼团购买 限时优惠

拼团购买 限时优惠